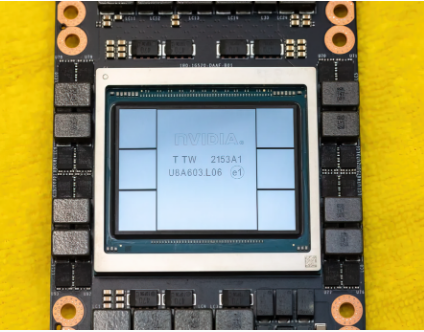

GTC 2022 上,NVIDIA推出了其 Hopper H100 GPU,这是一款专为下一代数据中心设计的计算引擎。自从我们谈论这款强大的芯片以来已经有一段时间了,但看起来 NVIDIA 将其旗舰芯片的特写镜头提供给了选择媒体。

NVIDIA Hopper H100 GPU:率先采用 4nm 和 HBM3 技术获得高分辨率图片

CNET不仅获得了融合 H100 GPU 的显卡,还获得了 H100 芯片本身。H100 GPU 是一款怪兽级芯片,采用最新的 4 纳米技术,并结合了 800 亿个晶体管以及最先进的 HBM3 内存技术。根据技术出口,H100 基于 PG520 PCB 板构建,该板具有 30 多个电源 VRM 和一个使用 TSMC 的 CoWoS 技术将 Hopper H100 GPU 与 6 堆栈 HBM3 设计相结合的大型集成中介层。

NVIDIA Hopper H100 GPU 图片(图片来源:CNET):

在六个堆栈中,保留两个堆栈以确保良率完整性。但是新的 HBM3 标准允许以 3 TB/s 的速度提供高达 80 GB 的容量,这太疯狂了。相比之下,目前最快的游戏显卡 RTX 3090 Ti 仅提供 1 TB/s 的带宽和 24 GB 的 VRAM 容量。除此之外,H100 Hopper GPU 还采用最新的 FP8 数据格式,通过其新的 SXM 连接,它有助于适应芯片设计的 700W 电源设计。

NVIDIA Hopper H100 GPU 规格一览

因此,按照规格,NVIDIA Hopper GH100 GPU 由一个巨大的 144 SM(流式多处理器)芯片布局组成,总共有 8 个 GPC。这些 GPC 共有 9 个 TPC,每个 TPC 进一步由 2 个 SM 单元组成。这使我们每个 GPC 有 18 个 SM,而在完整的 8 个 GPC 配置中,我们有 144 个。每个 SM 最多由 128 个 FP32 单元组成,这应该给我们总共 18,432 个 CUDA 内核。以下是您可以从 H100 芯片中获得的一些配置:

GH100 GPU 的完整实现包括以下单元:

英特尔 CEO Pat Gelsinger 预计到 2024 年芯片短缺将结束

8 个 GPC,72 个 TPC(9 个 TPC/GPC),2 个 SM/TPC,每个完整 GPU 144 个 SM

每个 SM 128 个 FP32 CUDA 核心,每个完整 GPU 18432 个 FP32 CUDA 核心

每个 SM 4 个第四代张量核心,每个完整 GPU 576 个

6 个 HBM3 或 HBM2e 堆栈,12 个 512 位内存控制器

60 MB 二级缓存